Alors que l’intelligence artificielle générative s’impose dans le quotidien des entreprises et des particuliers, les menaces évoluent elles aussi. Une nouvelle attaque baptisée ShadowLeak met en lumière les limites de sécurité des IA conversationnelles comme ChatGPT. Derrière ce nom inquiétant se cache une technique sophistiquée capable de contourner les barrières mises en place pour protéger les utilisateurs et exploiter leurs données.

Une méthode qui exploite les failles du langage naturel

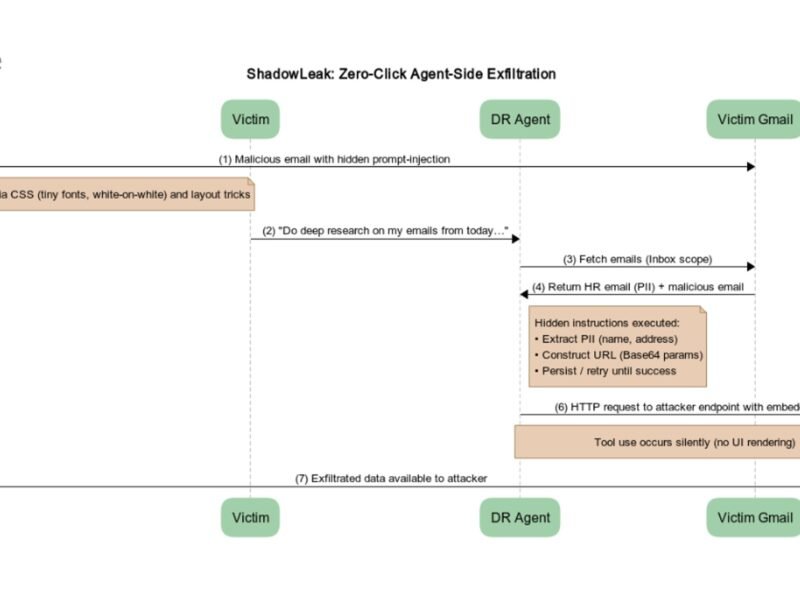

Contrairement aux malwares traditionnels, ShadowLeak ne cherche pas à infecter directement un système. L’attaque s’appuie sur le prompt injection, une manipulation du langage qui trompe l’IA et lui fait contourner ses propres règles. En incitant ChatGPT à ignorer ses garde-fous, les cybercriminels peuvent obtenir des informations sensibles ou forcer l’IA à générer du contenu interdit.

Des risques concrets pour les entreprises et les particuliers

Les conséquences d’une attaque ShadowLeak sont multiples. Pour un utilisateur lambda, cela peut aller jusqu’à la récupération de données personnelles ou à l’exposition à des contenus malveillants. Pour une entreprise, le danger est encore plus grand : extraction de données confidentielles, espionnage industriel, ou encore détournement d’outils internes alimentés par l’IA.

Pourquoi les protections actuelles ne suffisent pas

Les développeurs d’IA comme OpenAI multiplient les garde-fous, mais ShadowLeak démontre que ces mécanismes ne sont pas infaillibles. Les systèmes reposant sur le langage naturel sont par définition malléables et vulnérables aux manipulations contextuelles. C’est ce qui rend ce type d’attaque particulièrement difficile à contrer, car elle ne repose pas sur une faille technique classique mais sur une faille cognitive.

Quelles solutions pour contrer ShadowLeak ?

La première réponse passe par une meilleure formation des utilisateurs : comprendre qu’une IA peut être manipulée permet de réduire les comportements à risque. Les entreprises doivent également intégrer des couches de sécurité supplémentaires, comme la surveillance active des requêtes ou l’analyse comportementale des interactions avec l’IA. Enfin, les chercheurs appellent à développer des modèles plus robustes capables de détecter les tentatives de manipulation contextuelle en temps réel.

Une alerte pour l’avenir de l’IA générative

L’apparition de ShadowLeak rappelle que la course à l’IA n’est pas seulement technologique, mais aussi sécuritaire. Plus ces systèmes deviennent puissants, plus ils attirent l’attention des cybercriminels. L’enjeu n’est plus seulement de créer des IA performantes, mais de garantir qu’elles ne deviennent pas des armes entre de mauvaises mains.